参考文章:https://blog.csdn.net/MoreAction_/article/details/106443383

# 一、要解决的问题

在工程引用中,我们经常会用一组观测数据去估计模型的参数,模型是我们根据先验知识定下的。比如我们有一组观测数据 (xi,yi),i=1...n,通过一些数据分析我们猜测y 和x 之间存在线性关系,那么我们的模型就可以定为:

f(x)=kx+b

这个模型只有两个参数,所以理论上,我们只需要观测两组数据建立两个方程,即可解出两个未知数。类似的,假如模型有n 个参数,我们只需要观测n 组数据就可求出参数,换句话说,在这种情况下,模型的参数是唯一确定解。

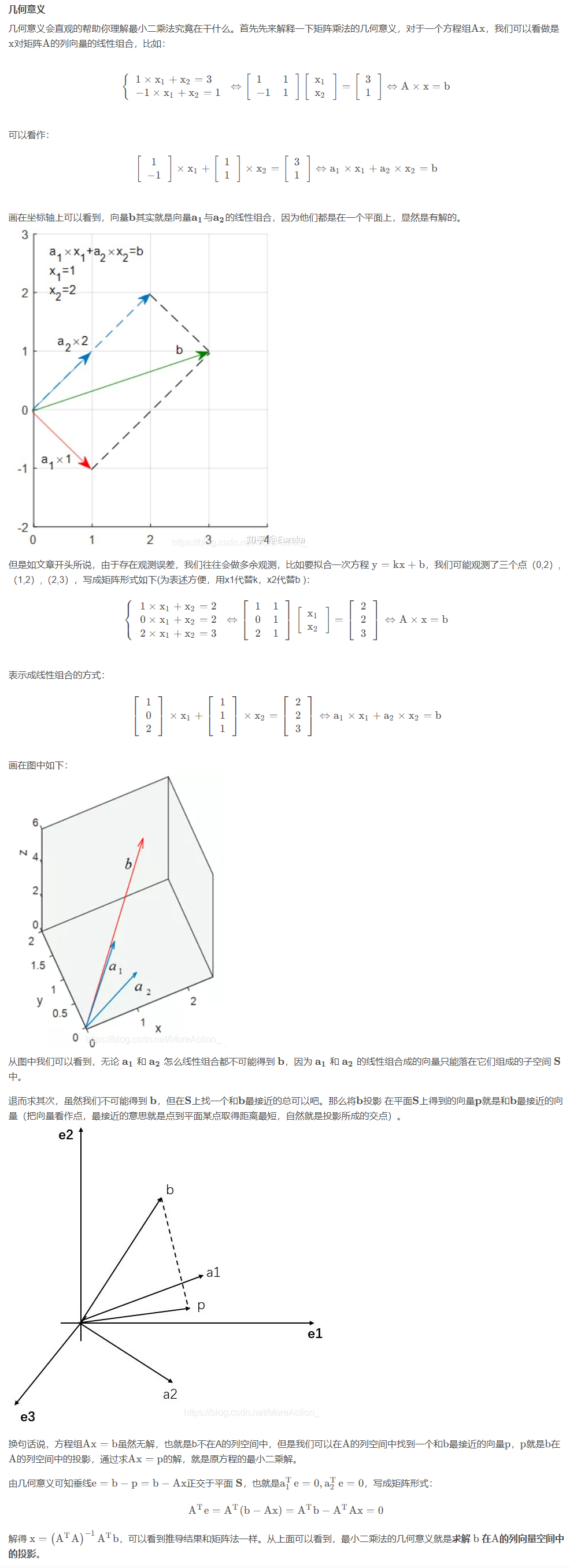

但是在实际应用中,由于我们的观测会存在误差(偶然误差、系统误差等),所以我们总会做多余观测。比如在上述例子中,尽管只有两个参数,但是我们可能会观测n 组数据(x1,y1),...,(xn,yn),这会导致我们无法找到一条直线经过所有的点,也就是说,方程无确定解。如下图所示:

![]()

于是这就是我们要解决的问题:虽然没有确定解,但是我们能不能求出近似解,使得模型能在各个观测点上达到 “最佳 “拟合。早在 19 世纪,勒让德就认为让 “误差的平方和最小” 估计出来的模型是最接近真实情形的。按照勒让德的最佳原则,于是就是求:

L=i=1∑n(yi−f(x))2

这个目标函数取得最小值时的函数参数,这就是最小二乘法的思想,所谓 “二乘” 就是平方的意思。从这里我们可以看到,最小二乘法其实就是用来做函数拟合的一种思想。

# 二、最小二乘法

线性回归定义为:hθ(x1,x2,...,xn−1)=θ0+θ1x1+...+θn−1xn−1,其中θ 是要求解的参数。假设现在有m 个样本,每一个样本都有n−1 维度的特征,将所有样本点带入模型中可得:

h1=θ0+θ1x1,1+θ2x1,2+…+θn−1x1,n−1 h2=θ0+θ1x2,1+θ2x2,2+…+θn−1x2,n−1⋮hm=θ0+θ1xm,1+θ2xm,2+…+θn−1xm,n−1

为方便用矩阵表示,我们令x0=I,于是上述方程可以用矩阵表示为:

h=Xθ

其中,h 为m×1 的向量,代表模型的估计值,θθ 为n×1 的向量,X 为m×n 维的矩阵,m 代表样本的个数,n 代表样本的特征数,于是目标损失函数用矩阵表示为:

J(θ)=∥h−Y∥2=∥Xθ−Y∥2=(Xθ−Y)T(Xθ−Y)

其中Y 是样本的标准输出向量,维度为m×1。对目标函数进行求导,并令其导数等于 0,可以得到:

∂θ∂J(θ)=2XTXθ−2XTY=0

解得:

θ=(XTX)−1XTY

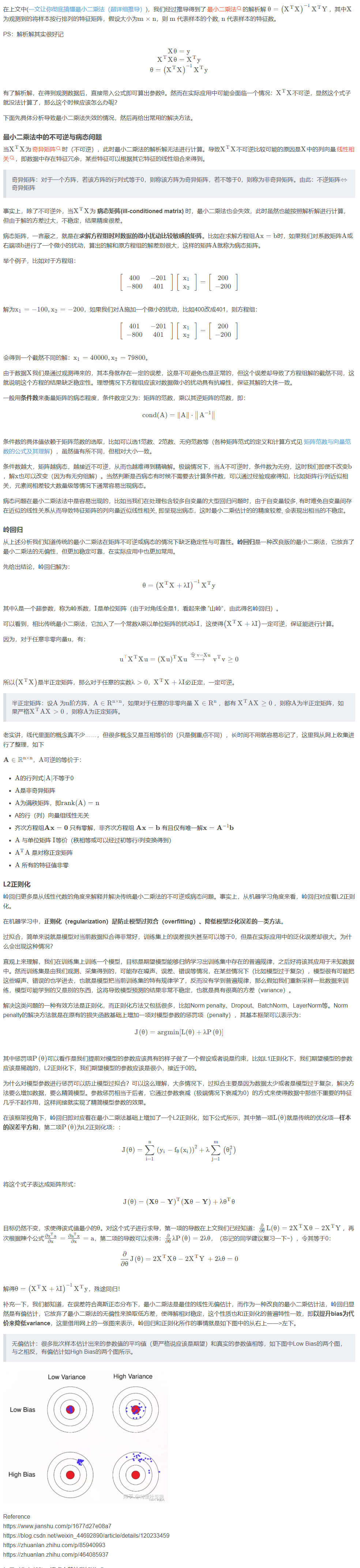

# 三、几何意义

![]()

# 四、岭回归

核心求解公式:

θ=(XTX+λI)−1XTY

![]()